NOBODY CARES, WE RUN ADS – Del reale controllo di Facebook

Vi presentiamo un altro incredibile articolo scritto da Claudio Ceruti, compagno ricercatore esperto di Intelligenza Artificiale, che ci aiuta a comprendere il fantastico mondo della Tecnologia Digitale.

NOBODY CARES, WE RUN ADS

Del reale controllo di Facebook

Alle 13.37 del 15 marzo scorso l’account di Brenton Tarrant inizia una diretta Facebook. Nel video, trasmesso da una camera GoPro, compare la moschea Al Noor di Christchurch, in Nuova Zelanda.

La camera inquadra un uomo all’ingresso della moschea pochi istanti prima che un colpo sparato dal fucile d’assalto di Tarrant lo getti a terra. Il bilancio finale della strage sarà di 50 morti.

Alle 13.46 la diretta Facebook termina, con un audience complessiva di circa 4mila utenti.

Alle 14.06 arriva la prima segnalazione del video ai moderatori di Facebook. Nelle 24 ore successive il team di controllo del contenuto eliminerà più di 1 milione e 500 mila copie del video circolanti sulla piattaforma del social network.

Nei giorni scorsi la compagnia di Menlo Park ha annunciato la cancellazione di tutte le pagine che fanno riferimento all’ideologia del white nationalism. Una risposta tardiva, che non risparmia a Facebook le critiche sull’incapacità di gestire il contenuto postato sulla piattaforma.

C’è da dire che molte di queste critiche non considerano la difficoltà tecnica di un tale controllo, che deve essere applicato in tempo reale a più di 1 milione di post al minuto. Al netto del lato tecnico, è però innegabile che questi problemi derivino anche dall’idea che Zucerkberg e soci hanno del social network.

Sin dagli inizi di Facebook, quando si chiamava ancora TheFacebook, il controllo dei contenuti non è stato infatti una priorità per i suoi fondatori. Per molto tempo, e anche con milioni di utenti registrati, la censura dei post è stata responsabilità di un’unica persona, che basava le proprie decisioni su scarne direttive riportate in uno striminzito documento. Per intenderci, regole del tipo “Nudity: bad, Hitler: bad”.

È solo recentemente che le cause legali e gli scandali hanno portato Facebook a dotarsi di un esercito di moderatori, tra i 15 e 30mila, buona parte dei quali precari e sottopagati, che analizzano circa 10 milioni di segnalazioni a settimana.

In pratica, prima di essere pubblicato, ogni contenuto passa al vaglio di un filtro di algoritmi di intelligenza artificiale, addestrati a riconoscere e rimuovere automaticamente ciò che non rispetta gli standard della comunità. Questi algoritmi sono praticamente infallibili per quanto riguarda il contenuto pornografico, mentre incespicano ancora quando incontrano l’hate speech, riuscendo a riconoscerlo solo il 38% delle volte, e solo se scritto in inglese o in portoghese.

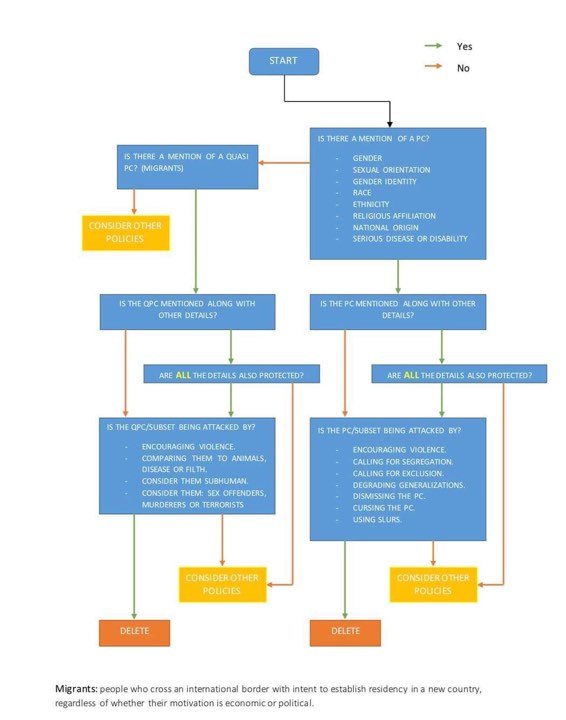

Nel caso che l’algoritmo sospetti, ma non sia certo, che ci sia una potenziale violazione, o nel caso di una segnalazione diretta da parte degli utenti, la palla passa al moderatore che osserva il contenuto e decide se vi sia il rispetto o meno degli standard della comunità. Per garantire una parvenza di oggettività, questo processo decisionale è governato da regole schematizzate in diagrammi di flusso if-then-else.

Osservando questi schemi appare subito evidente come non siano in grado di abbracciare la complessità e le sfumature del contenuto prodotto dagli utenti; il moderatore si trova così obbligato a deliberare basandosi sul proprio giudizio personale. È inevitabile quindi che vengano prodotte decisioni contradditorie, dove lo stesso contenuto viene approvato e censurato da moderatori diversi.

Lo stress derivante dalla pressione che i moderatori subiscono per produrre giudizi “corretti”, basandosi su regole iperschematizzate e al tempo stesso fumose e parziali, viene aggravato dal flusso continuo di immagini e contenuti che possono risultare fortemente scioccanti, come nel caso di omicidi, mutilazioni o suicidi in diretta. Numerosi sono i casi di lavoratori che hanno lamentato sintomi riconducibili a sindrome da stress post traumatico, tanto che alcuni di loro hanno anche fatto causa a Facebook per i danni psicologi riportati.

In generale, nelle interviste anonime rilasciate da alcuni ex dipendenti di società che hanno in appalto la moderazione per conto di Facebook, i lavoratori raccontano di essere sottoposti ad uno stress costante nel tentativo di stare al passo con i continui cambiamenti delle regole di moderazione, aggiornate quasi quotidianamente.

Modifiche così frequenti sono dovute al meccanismo di produzione della policy: le regole non vengono derivate da un codice etico ben definito, ma sono il risultato della gestione a posteriori di controversie causate da un determinato tipo di contenuto, come nel caso del massacro di Christchurch. È un continuo ricorso a soluzioni tampone, dove la moderazione dei contenuti risponde unicamente alla difesa della reputazione del brand. Tutto il resto viene posto sotto l’ipocrita tutela del free speech, che più che garantire la libertà di parola serve a Facebook per non porre filtri al contenuto prodotto dai suoi utenti.

Per monetizzare, Facebook ha bisogno che si pubblichi, che si produca senza limitazioni di sorta, indipendentemente dal cosa venga pubblicato.

“We run ads”, pubblichiamo pubblicità. Così rispose Zuckerberg all’audizione del congresso USA per lo scandalo Cambridge Analytica, quando un senatore gli chiese quale fosse il modello di business dietro Facebook.

“We run ads”.

Tre semplici parole che racchiudono la natura di Facebook, che forgiano la struttura stessa del social network.

Il grafo che Facebook costruisce sulle nostre relazioni e interazioni sul social, è funzionale esclusivamente alla distribuzione di pubblicità.

Più un contenuto è virale, più si diffonde, più utenti raggiunge, più like riceve, più preferenze vengono registrate, più utenti vengono profilati e più profili impacchettati e venduti ai pubblicitari.

Non importa se il contenuto virale sia fake o meno. D’altronde, cosa c’è di più fake della pubblicità?

Ma come siamo finiti in questa gigantesca rete a servizio dei pubblicitari?

Per capirlo, bisogna tornare alle origini di Facebook, ai tempi di TheFacebook.

In quegli anni Zuckerberg vive alla Kirkland House, uno studentato di Harvard, una delle più prestigiose università del mondo. Non fa però parte delle confraternite studentesche che contano, il cui accesso è sottoposto ad un rigoroso processo di selezione.

Essere parte di una confraternita, al di là dell’immaginario alla Animal House di feste e birra, significa entrare in un network di contatti che si estende al di fuori e oltre l’università. Le confraternite più importanti del paese sono infatti il vivaio in cui viene coltivata la classe dirigente americana: l’85% di tutti i giudici eletti alla corte suprema ha fatto parte di una confraternita, così come il 76% dei senatori e l’85% degli amministratori delle più grandi compagnie americane. La sola Delta Kappa Epsilon di Yale ha avuto 5 presidenti degli USA tra i suoi membri, tra cui i Bush, padre e figlio, e Roosevelt.

Le confraternite, con la loro influenza, si trovano all’apice di un complesso agglomerato di reti sociali che permeano il campus universitario, dai club del cinema a quello degli atleti, il cui valore viene misurato in termini di quanto siano esclusive.

Zuckerberg, per primo e più o meno consapevolmente, sfrutta il potere di queste reti servendosi del desiderio di farvi parte che viene condiviso da buona parte degli studenti del campus. Attraverso TheFacebook le informali reti sociali universitarie vengono digitalizzate in una piattaforma che ne permette l’accesso distribuito, la condivisione dei contenuti e al tempo stesso la crescita delle reti stesse.

Questo è il colpo da maestro che ha permesso a TheFacebook di battere i concorrenti di allora, come MySpace: l’algoritmo è stato in grado di partire dalla cattura di potentissime reti sociali, e di crescere imitandone le modalità di funzionamento, come il fare amicizia, comunicare ai propri contatti, approvare i contenuti, etc.

Dalla data di lancio, 4 febbraio 2004, passano solo 10 mesi e Facebook ha già un milione di utenti. Una crescita che ad oggi porta a 2.32 miliardi il numero di utenti attivi mensilmente, circa 1 persona su 3 nel mondo.

Una scala così ampia da modificare il termine social network, rete sociale, non più riferito a quell’insieme di relazioni che si costruiscono tra individui accomunati da caratteristiche condivise, ma solo alle piattaforme digitali costruite su di esso.

Nella sua digitalizzazione però Facebook trasforma la rete sociale: il contenuto che fluisce tra i suoi nodi non è il prodotto della libera e spontanea creazione collettiva, ma è l’incanalamento di questo prodotto nelle coordinate della diffusione pubblicitaria, della profilazione degli utenti e dell’estensione del grafo.

Le reti sociali vengono così intrappolate da un meccanismo che le vampirizza e le mette a lavoro. Gli utenti si trovano così rinchiusi in bolle, echo chamber, in un loop continuo di contenuti simili che l’algoritmo decreta adeguati per noi mentre ci analizza.

Si perde così la vera potenza di una rete sociale, quello di poter rimanere sul “bordo”: nella teoria matematica dell’innovazione, i bordi di una rete sociale, cioè i nodi/contatti a cui siamo connessi ma sono i più distanti da noi, sono quelli che si affacciano nella cosiddetta area dell’adiacente possibile. Questa area è vicina a noi (l’adiacente) ma è quella dove si celano i contenuti e le relazioni nuove, inesplorate (il possibile). Arrivare nell’area dell’adiacente possibile ci permette di esplorare nuove combinazioni del noi con una realtà potenziale ma non ancora verificatasi. La ricchezza delle reti sociali sta proprio nella possibilità di aprire strade verso alternative future che ci trasformano e trasformano le reti sociali stesse, in un continuo accrescimento esplorativo.

La mortificazione digitale delle reti ne castra però questa potenza in favore di un contenimento dell’utente in oggetto della profilazione e soggetto della pubblicità: utenti rinchiusi in isole-prigioni, iperconnessi nella rete ma al tempo stesso separati dalla rete stessa.

Considerando oggi la visione dei pionieri di Internet, quell’utopia digitale fondata sulla libertà attraverso la connettività, ci scontriamo così con una realtà di una rete che non ci ha reso liberi, tutt’altro. Ma ciò non è dovuto all’assenza di potenzialità liberatorie della rete, quanto alla rapacità del capitale che le ha distorte e subordinate al profitto.

Nonostante la vastità del dominio capitalistico delle tecnologie, ci si può ancora affacciare al nostro adiacente possibile, scrutare nelle alternative al bordo della bolla.

Per farlo però, serve uno sguardo nuovo, iniziando a pensare, ad esempio, che nella dimensione algoritmica ogni news è fake, ogni like è profilazione, ogni contatto un canale da vendere. Smetterla di pensare che Facebook sia una piattaforma neutra, non perché favorisca un certo tipo di messaggio piuttosto che un altro, ma perché somma di reti sociali dominata dal capitale. E come tale regole e regolamentazioni sono solo funzionali alla fluidità del capitale stesso, al mantenimento del profitto.

E per i più smanettoni, iniziare anche ad indagare modelli alternativi, come le reti decentralizzate (https://solid.mit.edu/ ) su cui si basano nuovi social network come mastodn (https://youtu.be/IPSbNdBmWKE).

Il nostro adiacente possibile è li. Aspetta solo che lo raggiungiamo.

Ceru

Tag:

facebook intelligenza artifical tecnologia