La guerra e l’AI: il paradigma della Palestina

Martedì 18 giugno all’ex chiesetta del parco Trotter si è svolto l’incontro “La guerra e l’AI: il paradigma della Palestina”, organizzato da N.I.N.A watch, un gruppo nato con lo scopo di esplorare quale sarà l’impatto dell’intelligenza artificiale su diverse aree tematiche.

Con il contributo delle relatrici Rajaa Ibnou per GazaFREE style, Lavinia Parsi, dottoranda di ricerca in diritto penale internazionale presso l’Università degli Studi di Milano e la Humboldt – Univesität di Berlino e il giornalista Maurizio Bongioanni, il tema è stato affrontato ponendo il focus su ciò che sta succedendo a Gaza e in tutta la Palestina.

I palestinesi sono uno dei popoli più sorvegliati al mondo. Da decenni il governo israeliano raccoglie dati sulla loro vita, sulle loro interazioni e anche sulla loro morte, con l’apparente motivo di intimidazione, in linea con le condizioni di controllo e repressione che un regime di apartheid impone al popolo indigeno.

Ma dall’inizio della campagna genocida a Gaza è stata ancor più chiara la natura di questa raccolta di dati in zona di guerra, perché quest’ultimi sono oggi utilizzati per alimentare le piattaforme di intelligenza artificiale che stanno massacrando ininterrottamente migliaia di civili.

Ma facciamo un passo indietro.

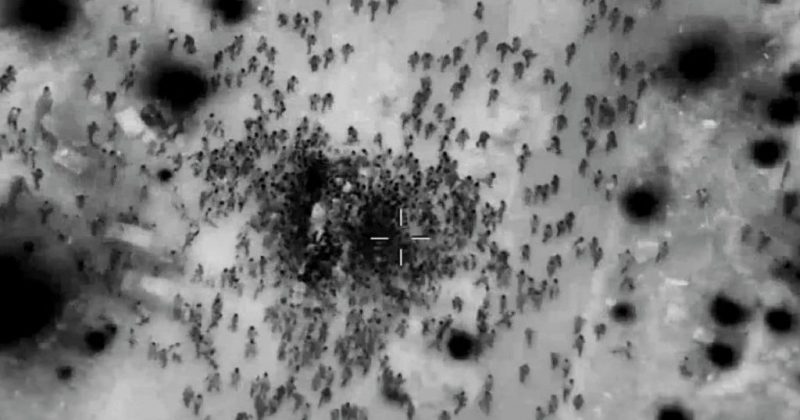

Non sono poche le figure autorevoli nel campo del diritto internazionale che hanno sollevato dubbi sulla compatibilità delle tecnologie AI con i diritti umani. La sorveglianza biometrica di massa, che a Gaza è stata effettuata per anni prima del 7 ottobre 2023, con l’utilizzo di droni di monitoraggio, permette la raccolta di dati in maniera rapida e senza il consenso della persona coinvolta; questi stessi dati sottratti senza il consenso, possono essere ritorti contro le persone sottoposte al controllo, come sta succedendo ora a Gaza.

Infatti il governo israeliano, che per 17 anni aveva già utilizzato Gaza come laboratorio tecnologico sperimentale per armi che successivamente vendeva all’estero come “già testate”, oggi sta permettendo al proprio esercito di sterminare centinaia di migliaia di persone con l’utilizzo di tre (quelli noti) sistemi di intelligenza artificiale:

1. LAVANDER (Lavanda): Dopo l’inserimento manuale di requisiti per l’identificazione di militanti di Hamas o della Jihad islamica, il sistema Lavander – grazie ai dati raccolti dal decennale controllo biometrico degli abitanti di Gaza – genera potenziali obiettivi.

+972 Magazine, il giornale che ha pubblicato per primo l’inchiesta sull’utilizzo di piattaforme non conformi, ha diffuso varie interviste di agenti dell’intelligence israeliana. “Al suo apice,” ha dichiarato uno degli agenti rimasti chiaramente in incognito, “il sistema è riuscito a generare 37mila persone come potenziali target. Ma i numeri cambiavano continuamente, perchè dipende da dove si fissa il livello di ciò che è un agente di Hamas. Ci sono momenti in cui la definizione di Hamas era più ampia, e la macchina ci ha portato a personale della protezione civile, agenti di polizia…“. Per i “militanti di basso rango”, così classificati dagli ufficiali a guida del sistema Lavander, vengono utilizzate delle “bombe stupide”, e cioè delle munizioni non guidate lanciate contro complessi abitativi.

2. GOSPEL (Vangelo): Il sistema viene utilizzato come Lavander ed indica prevalentemente edifici e strutture che rientrano nella definizione di base operativa di Hamas o della Jihad. Come non ricordare le prime volte, ad ottobre, in cui l’esercito israeliano ha iniziato a colpire scuole, ospedali e aree densamente abitate. Dopo più di 250 giorni di aggressione militare e la distruzione di tutte le infrastrutture e dell’80% dei complessi abitativi, è chiaro che l’inserimento dei dati che hanno generato gli obiettivi di Gospel includono tutta Gaza.

3. WHERE IS DADDY’?: Il sistema spia, tramite intercettazioni telefoniche, messaggi social e quant’altro, tutti gli abitanti di Gaza allo scopo di individuare gli ipotetici militanti di Hamas. Questi vengono poi classificati secondo la loro presunta pericolosità e sorvegliati attraverso un sistema di tracciamento che con incredibile e aberrante cinismo viene chiamato “Dov’è papà?”, per essere poi colpiti nel momento esatto in cui rientrano a casa in modo da sopprimerli, eliminando l’intera famiglia, bambini compresi. Dall’inizio del genocidio, a Gaza sono state completamente cancellate più di 1500 famiglie.

Chiaramente l’intelligence israeliana afferma che la precisione di Lavander è pari al 90%. Anche se questo dato risultasse paradossalmente vero, quel 10% di errore non sarebbe stato tollerabile in una guerra convenzionale, dove si affrontano due eserciti e i civili come i prigionieri, sono protetti da convenzioni internazionali a responsabilità diretta, in caso di violazione, della persona a comando. Se si riuscisse a provare che la distruzione degli ospedali Al Shifa, Nasser, Al Aqsa o Al Awda sono state indicate da un sistema AI che ha elaborato dei dati inseriti manualmente dal responsabile d’intelligence di turno, a chi verrebbe imputato il fallimento di quelle operazioni inconcludenti all’interno degli ospedali che hanno causato migliaia di vittime?

Se si provasse che i massacri a Rafah, Deir Al Balah, Gaza City, Nuseirat sono stati comandati da questa nuova tecnologia bellica testata sui palestinesi, chi dovrà essere accusato di crimini di guerra?: Chi ha elaborato il software di Lavander, Gospel, WID oppure l’agente di turno o l’attuale capo di governo israeliano?

Grazie all’AI la responsabilità umana può essere sostituita dalla patina dell’obiettività algoritmica, come se “più dati” significasse “previsioni migliori“.

L’impatto devastante in tempi di guerra lo stiamo vedendo oggi a Gaza, con +40mila morti di cui il 70% di loro erano donne e bambin*.

La riduzione degli esseri umani a dati statistici, in guerra come in pace, porta a conseguenze irreversibili per la dignità, la sicurezza e la vita delle persone.

Le infrastrutture di sorveglianza, i database biometrici e altri strumenti di controllo quotidiani anche nelle società che si professano democratiche, consentono di utilizzare sistemi come Lavander e Gospel in zone di guerra.

Oggi tali sistemi sono testati per la prima volta nella storia su un gruppo di persone rinchiuso in pochi kilometri quadrati senza nessuna via di fuga, una vera e propria sperimentazione in un laboratorio dove la carne umana viene macellata da quadricotteri telecomandati con mitraglietta, munizioni direzionate o non-guidate e bombe di ogni peso o misura.

Per non parlare, in aggiunta, del cinismo e della ferocia portata avanti dai soldati che giocano con le vite dei civili palestinesi, rendendo anche pubblico sui social le loro provocazioni.

Per approvare il lancio di un colpo contro il bersaglio (la persona) generato dal sistema, il soldato di turno ha in media 10 secondi quando ci sono delle persone nei paraggi. Il tempo che gli è stato concesso per capire se si tratta di un uomo, prediligendo le persone giovani di sesso maschile per procedere al lancio.

Per ogni militante di basso rango possono essere uccise una media di 20 civili, secondo confessione di alcuni soldati israeliani. Se il sistema intercetta una persona che, secondo i dati inseriti, viene considerata altolocata nella gerarchia politica di Hamas, possono essere uccise fino a 120 persone civili.

Infine, un ultimo dato importante da considerare per comprendere ancor meglio la portata distruttiva di sistemi che generano autonomamente bersagli di guerra, è il numero di persone appartenenti ad Hamas stimato da israele e USA prima del 7 ottobre 2023; si riteneva infatti che i membri dell’ala militare di Hamas dentro Gaza fossero tra i 25 e i 30mila. Un numero che il sistema Lavander ha di gran lunga superato dopo l’aggiornamento di dati effettuato pochi giorni prima dell’inizio dell’invasione via terra di Gaza.

Uccidere con la freddezza dell’AI rende sicuramente un massacro più semplice..

La guerra tecnologica e l’utilizzo del sistema AI contro persone – civili o combattenti che siano – non ha ancora oggi nessuno tipo di “regolamentazione” o controllo terzo. I software vengono continuamente perfezionati per de-responsabilizzare sempre di più la supervisione umana, con sistemi AI di machine learning dove la macchina sviluppa autonomamente algoritmi e decisioni sulla base della raccolta dati precedentemente effettuata (tramite Google ma anche le piattaforme social META, per arrivare fino al controllo biometrico non autorizzato).

Le infrastrutture di sorveglianza e gli strumenti di riconoscimento e controllo stanno permettendo la raccolta di dati necessari per alimentare tecnologie incompatibili con i diritti umani; sono devastanti in tempo di guerra e pericolose in tempo di pace.

Il tema sicuramente continuerà ad essere oggetto di studio critico per il gruppo N.I.N.A. Watch, acronimo di “Né intelligente né artificiale”, dal titolo del libro di Kate Crawford.

Nel frattempo, lottare per la liberazione della Palestina e un urgente e permanente cessate il fuoco su Gaza, diventa più che mai necessario. Anche in nome di ciò che resta dell’umanità, il cui significato è più precario che mai.

Tag:

AI algoritmi diritti umani esercito israeliano gaza gazawi genocidio guerra hamas idf intelligenza artificiale israele massacro Netanyahu Palestina palestinesi strage striscia di gaza